دیپ فیک؛ خطرناک مثل بمب هسته ای

به گزارش راه ساری، اولین بار از این فناوری در شبکه اجتماعی ردیت رونمایی شد؛ زمانی که فردی با نام کاربری دیپ فیک ویدئویی تقلبی را در این برنامه به اشتراک گذاشت. در این ویدئو ها صورت بازیگران معروف با یکدیگر جابه جا شده بود و این مسئله توجه بسیاری را به خود جلب کرد.

امین وصالی| پیشرفت فناوری نوین دیپ فیک، کاربران این روز ها بیش از همیشه در فضای مجازی احساس خطر می نمایند. دیپ فیک اصطلاحی است که طی سال های اخیر بسیار در فضای مجازی مورد استفاده قرار گرفته است.

دیپ فیک در واقع نام فرآیندی است که طی آن یک یا چند کاربر محتوایی غیر واقعی را در فضای مجازی منتشر می نمایند تا کاربران را گمراه نمایند و ویدئو یا دیگر محتوا های درست شده را در قالب مدرکی اصل به افراد ارائه دهند.

در حالی که فناوری دیپ فیک پیش از این تنها در دستان سازمان های اطلاعاتی مانند CIA بود، امروزه هر کاربری می تواند با دانلود برنامه های فراوری ویدئوی دیپ فیک به این فناوری دست پیدا کند و از آن برای اهداف غیراخلاقی استفاده کند.

با این وجود، یک ویدئوی دیپ فیک می تواند اشخاصی را که آگاهی کامل ندارند گمراه کند و یا در مواردی زندگی آن فرد را از بین ببرد. تا به امروز ویدئو های بسیاری ساخته و منتشر شده اند که ذهن کاربران را مشغول خود نموده بودند.

کاربران با استفاده از فناوری دیپ فیک ویدئویی ساخته بودند که در آن مارک زاکربرگ، مدیرعامل فیسبوک، ادعا می کرد بر روی اطلاعات خصوصی میلیارد ها انسان کنترل کامل دارد.

آیا دیپ فیک تنها شامل ویدئو های تقلبی می گردد؟

خیر. دیپ فیک یک فناوری است که می توان با استفاده از آن تصاویری طبیعی را بدون وجود هیچ عکس دیگری فراوری کرد. برای مثال مدتی پیش محققان متوجه شدند یکی از خبرنگاران بلومبرگ که با نام میسی کینزلی در شبکه های اجتماعی لینکدین و توئیتر نیز حساب کاربری داشت کاملاً شخصیتی غیر واقعی و ساخته شده توسط فناوری دیپ فیک بوده است.

یک فرد دیگر در این شبکه های اجتماعی با نام کیتی جنز حضور داشت که بعد ها تعیین شد با استفاده از فناوری دیپ فیک برای به دام انداختن جاسوس های خارجی ساخته شده است. در ادامه باید گفت فایل های صوتی نیز امکان ساخته شدن توسط دیپ فیک را دارند.

قویترین ویدئو های دیپ فیک

به عنوان مثال چند ماه پیش یکی از رؤسای انگلیسی یک شرکت آلمانی 200 هزار یورو را به حساب بانکی فردی در مجارستان فرستاد چرا که کلاهبردار مورد نظر توانسته بود صدای مدیرعامل شرکت آلمانی را توسط فناوری دیپ فیک بازسازی کند.

با وجود آن که مسئولان شرکت مورد نظر و همچنین مدیرعامل این مجموعه گفتند تماس صوتی انجام شده تقلبی است، اما هیچ مدرکی برای اثبات چنین مسئله ای در دسترس قرار ندارد. لازم به ذکر است؛ چنین اتفاقاتی طی سال های گذشته به مراتب اتفاق افتاده و بسیاری از آن ها نیز به وسیله برنامه واتساپ انجام شده اند.

نحوه ساخت ویدئو های دیپ فیک

محققان بسیاری طی سال های گذشته سعی داشتند با استفاده از فناوری های مختلف و نرم افزار های ساخت ویدئو امکان فراوری محتوای غیر واقعی را مورد آنالیز قرار دهند. اما فناوری دیپ فیک به خودی خود در سال 2017 پا به جهان گگردد.

اولین بار از این فناوری در شبکه اجتماعی ردیت رونمایی شد؛ زمانی که فردی با نام کاربری دیپ فیک ویدئویی تقلبی را در این برنامه به اشتراک گذاشت. در این ویدئو ها صورت بازیگران معروف با یکدیگر جابه جا شده بود و این مسئله توجه بسیاری را به خود جلب کرد.

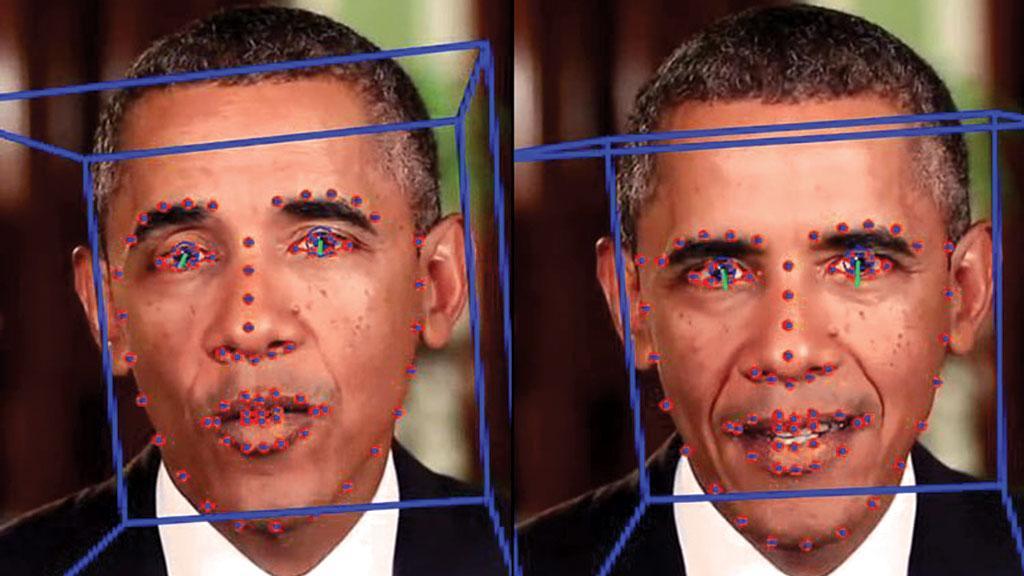

تعویض صورت دو فرد در ویدئو به صورت دستی کار بسیار سختی است چرا که فرد احتیاج دارد ابتدا از صورت افراد در تمامی فریم های ویدئو عکس جداگانه بگیرد و سپس مراحل دیگر را انجام دهد، اما با استفاده از دیپ فیک این اتفاق به راحتی صورت می گیرد.

در این فرآیند هوش مصنوعی هزاران تصویر را از صورت فرد مورد نظر ثبت می نماید که با عنوان رمزگذار شناخته می گردد. این رمزگذار شباهت های بین صورت دو فرد را تشخیص می دهد و با توجه به آن ها تصاویری دریافت شده را جایگذاری می نماید.

در مرحله دوم فرآیندی به نام رمزگشا آغاز می گردد که با توجه به تفاوت های هر صورت سعی می نماید تعویض چهره ها را طبیعی تر جلوه دهد. در واقع تصاویر رمزگذاری شده فرد الف به فرآیند رمزگشایی فرد ب ارسال می گردد تا تغییر تصاویر صورت گیرد. این فرآیند برای تمامی فریم های یک ویدئو صورت می گیرد که ممکن است از هزاران تا میلیون ها نمونه باشد.

در نوع دیگر ساخت ویدئو های دیپ فیک دو هوش مصنوعی با الگوریتم های مختلف با هم همکاری می نمایند تا تصویر ها ساخته شوند. طی این فرآیند یک ژنراتور و یک تفکیک نماینده وجود دارد.

همان طور که از نام این دو پیدا است، ژنراتور وظیفه فراوری تصاویر را دارد و تفکیک نماینده تشخیص می دهد که کدام عکس ها برای استفاده مناسب هستند. تصاویر فراوری شده در مرحله اول کاملا خام هستند، اما با گذر زمان کاربر شاهد تشکیل یک تصویر و یا ویدئوی فوق حرفه ای خواهد بود.

چه کسانی ویدئوی دیپ فیک فراوری می نمایند؟

تمامی افراد از کاربران ساده تا محققان جهانی فناوری و سازندگان فیلم های سینمایی از چنین فناوری نوینی استفاده می نمایند. همچنین گفته می گردد دولت های کشور های بسیاری نیز برای بعضی اقدامات خود این فناوری را مورد استفاده قرار می دهند. لازم به ذکر است؛ بیشترین میزان استفاده از این فناوری متعلق به کلاهبرداران و سوءاستفاده گران اینترنتی است.

دیپ فیک چقدر خطرناک است؟

از زمان پیدایش فناوری دیپ فیک نگرانی بسیاری از کاربران فضای مجازی افزایش یافته است. این نگرانی به قدری است که نماینده حزب جمهوری خواه آمریکا در سال 2016 قدرت فناوری دیپ فیک را با سلاح هسته ای مقایسه کرد. وی طی صحبت های خود گفت: اگر کسی می خواست در گذشته آمریکا را تهدید کند تنها به چند سلاح هسته ای و موشک احتیاج داشت.

امروزه تنها کافی است که کشوری به سیستم اینترنتی آمریکا دسترسی پیدا کند. تنها چیزی که برای آسیب زدن به ما احتیاج می گردد امکان فراوری محتوا های غیر واقعی و ویدئو های تقلبی بسیار واقع گرایانه است.

تصاویر ساخته شده توسط دیپ فیک

با وجود این سخنان تیم هاونگ، مدیر اجرایی تحقیقات هوش مصنوعی دولت آمریکا سرسختانه مخالفت خود را نشان داده و در واکنش به صحبت های این نماینده سیاسی گفت که بعید می داند این فناوری به قدرتمندی بمب اتم باشد.

وی گفت: من فکر می کنم از این فناوری استفاده های غیر اخلاقی بسیاری می گردد و معتقد هستم این رفتار ها نگرانی اشخاص را افزایش می دهد، با این وجود شک دارم فناوری دیپ فیک چندان تغییر عظیمی در جهان به وجود بیاورد و آسیب های گسترده ای را وارد کند.

در مجموع باید گفت دیپ فیک نمی تواند در مقیاس بالا آسیبی را به یک کشور وارد کند، اما افراد سوءاستفاده گر می توانند از این فناوری برای باج گیری و یا آسیب زدن به کاربران عادی استفاده نمایند.

فناوری شلو فیک که از قدرت کمتری نسبت به دیپ فیک برخوردار است نیز می تواند آسیب های مشابه ای را به جامعه برساند. برای مثال مدتی پیش طی یکی از جلسات سخنرانی دونالد ترامپ، رئیس جمهور آمریکا، جیم آکستا که از طرف شبکه CNN فرستاده شد سوالاتی پرسید و ترامپ را به چالش کشید.

به دنبال این عمل یکی از کارمندان کاخ سفید تصمیم گرفت میکروفن را از دست او بکشد و به صحبت های او انتها دهد.

در حالی که ویدئوی اصلی این اتفاق در فضای مجازی وجود دارد، اما نمونه ای دستکاری شده از آن نیز منتشر شده که نشان می دهد خبرنگار مذکور به کارمند کاخ سفید حمله می نماید. انتشار چنین ویدئویی باعث شد ترس کاربران از فناوری دیپ فیک و شلو فیک بیشتر گردد چرا که با وجود چنین ابزار هایی تمامی ویدئو ها به ساده ترین شکل ممکن قابل دستکاری هستند.

می توان گفت تشخیص ویدئو های دیپ فیک که با کیفیت بالا طراحی شده اند بسیار سخت است. از طرف دیگر ویدئو های دیپ فیک که توسط کاربران و با برنامه های اینترنتی ساخته می شوند به راحتی قابل تشخیص هستند چرا که زمان زیادی صرف ساخت آن ها نمی شوند.

ویدئو هایی که توسط فرآیند GAN، دومین مدل ساخت دیپ فیک ها، ساخته می شوند معمولا از کیفیت بالاتری برخوردار هستند و بیشتر مواقع کاربران برای تشخیص آن ها احتیاج به یک هوش مصنوعی دیگر دارند.

در حال حاضر شرکت های تحقیقاتی بسیاری سعی دارند روش های قابل اعتماد تری را برای تشخیص ویدئو های دیپ فیک قوی پیدا نمایند.

با این حال از آن جایی که فرآیند GAN از دو هوش مصنوعی برای فراوری ویدئو ها بهره می برد امکان تشخیص ویدئو های آن ها همیشه در حال سخت تر شدن است. همان طور که بسیاری از کاربران آگاه هستند، هوش های مصنوعی می توانند مسائل جدید را یاد بگیرند و ایرادات خود را در طی زمان رفع نمایند.

در واقع اگر یک فرد تمامی اطلاعات مربوط به تشخیص ویدئو های دیپ فیک را در اختیار هوش های مصنوعی GAN قرار دهد دیگر هیچ راهی برای تشخیص صحت آن ها وجود نخواهد داشت. چنین مسئله ای باعث از بین رفتن اعتماد به محتوای قرار گرفته شده در اینترنت و رسانه ها می گردد. با تمامی این مسائل محققان همچنان باور دارند راهی برای تشخیص صحت ویدئو ها پیدا خواهد شد.

به دنبال این مسائل کاربران فضای مجازی باید مراقب تصاویری که در شبکه های اجتماعی قرار می دهند باشند. همان طور که مدتی پیش ربات هایی در تلگرام برای ساخت محتوای غیر اخلاقی توسط تصویر کاربران ساخته شده بود و افراد زیادی مورد سوءاستفاده قرار گرفتند، هر شخصی که افراد ناشناس را در صفحات خود راه می دهد ممکن است در معرض چنین خطر هایی قرار گیرد.

منبع: فرادیدبالی: سفر به جزیره ای شگفت انگیز در اندونزی